Synopsis: 爬取 www.mzitu.com 全站图片,截至目前共 5162 个图集,16.5 万多张美女图片,使用 asyncio 和 aiohttp 实现的异步版本只需要不到 2 小时就能爬取完成。按日期创建图集目录,保存更合理。控制台只显示下载的进度条,详细信息保存在日志文件中。支持异常处理,不会终止爬虫程序。失败的请求,下次再执行爬虫程序时会自动下载

代码已上传到 https://github.com/wangy8961/python3-concurrency-pics-02 ,欢迎 star

1. 准备环境

1.1 安装 CentOS

建议使用 VMware 安装一台 CentOS-7.3 虚拟机,请参考: http://www.madmalls.com/blog/post/customize-centos-7-3-autoinstall-iso/

1.2 安装 Python3

请参考: http://www.madmalls.com/blog/post/deploy-flask-gunicorn-nginx-supervisor-on-centos7/#3-python3

1.3 安装 MongoDB

请参考: http://www.madmalls.com/blog/post/deploy-flask-gunicorn-nginx-supervisor-on-centos7/#4-mongodb ,如果是 Windows 请参考: http://www.madmalls.com/blog/post/win10-install-mongodb/

尝试使用

motor实现 MongoDB 异步操作,好像效率更差一些,所以放弃使用该模块。目前数据库操作是同步阻塞型,使用pymongo模块

1.4 安装 Git

[root@CentOS ~]# yum -y install git

代码已上传到 https://github.com/wangy8961/python3-concurrency-pics-02 ,欢迎 star,克隆代码:

[root@CentOS ~]# git clone https://github.com/wangy8961/python3-concurrency-pics-02.git [root@CentOS ~]# cd python3-concurrency-pics-02/

1.5 准备虚拟环境

如果你的操作系统是 Linux:

[root@CentOS python3-concurrency-pics-02]# python3 -m venv venv3 [root@CentOS python3-concurrency-pics-02]# source venv3/bin/activate

Windows激活虚拟环境的命令是:venv3\Scripts\activate

1.6 安装依赖包

如果你的操作系统是 Linux:

(venv3) [root@CentOS python3-concurrency-pics-02]# pip install -r requirements-linux.txt

如果你的操作系统是 Windows(不会使用 uvloop):

(venv3) C:\Users\wangy> pip install -r requirements-win32.txt

2. 分析过程

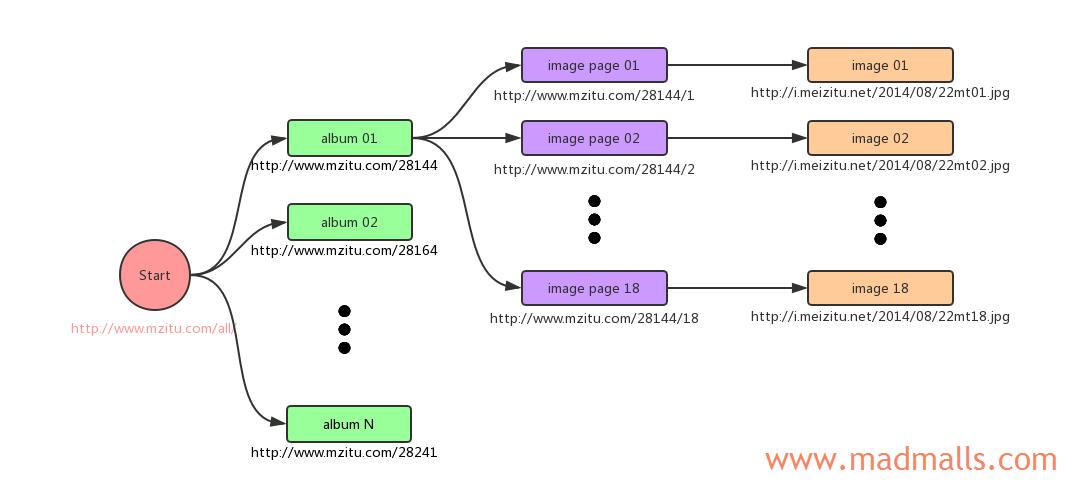

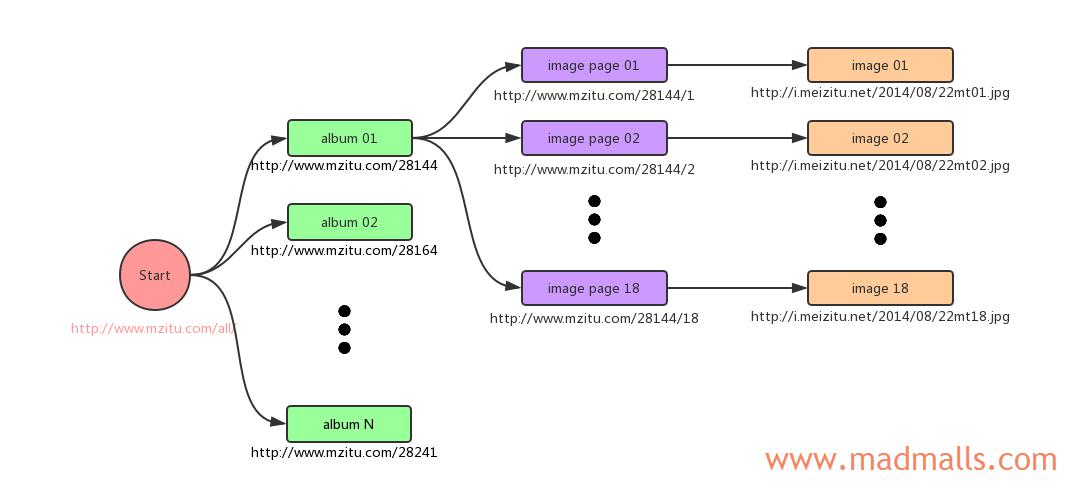

2.1 获取图集信息

使用 requests 模块或 aiohttp 模块来获取入口页面 http://www.mzitu.com/all/ 的 HTML 响应,然后通过 BeautifulSoup4 和 lxml 来解析 HTML 文档。每个 图集 按年份/月份被放在 <div class='all'></div> 下面的每个 <a href="图集URL">图集标题<a> 中。需要注意的是,早期图片需要访问 http://www.mzitu.com/old/ ,递归调用获取图集的函数即可

将获取的 5000 多个图集信息保存到 MongoDB 数据库的 albums 集合中

访问 http://www.mzitu.com/all/ 和 http://www.mzitu.com/old/ ,共

2 次请求

2.2 获取包含图片的页面信息

每个图集下面的图片数量不相同,我们需要依次访问图集 URL,通过 分页导航栏 获取该图集下最大的图片数和它的发布时间,并在本地磁盘上创建按日期分类的目录,方便以后浏览图片

假设图集 URL 为 http://www.mzitu.com/56918 ,发现该图集下有 47 张图片,而且包含图片的页面 URL 也是有规律的,比如包含第 1 张图片的页面 URL 为 http://www.mzitu.com/56918/1

将每个图集下面的包含图片的页面信息保存到 MongoDB 数据库的 image_pages 集合中

依次访问图集 URL,共

5000 多次请求

2.3 获取图片的真实 URL

我们通过访问每个包含图片的页面,获取每张图片的真实 URL,并保存到 MongoDB 数据库的 images 集合中

依次访问包含图片的页面 URL,共

16 万多次请求

2.4 下载图片

从 MongoDB 数据库的 images 集合中获取所有图片的真实 URL,依次下载并保存到本地

依次访问图片的真实 URL,共

16 万多次请求

3. 使用

3.1 测试

由于图片有 16 万多张,所以测试的时候,你可以指定只下载 100 个图集来对比 同步下载、多线程下载 和 异步下载 的效率区别,修改以下三个脚本中的 TEST_NUM = 100

建议每次测试完,都删除相关目录:

(venv3) [root@CentOS python3-concurrency-pics-02]# rm -rf downloads/ logs/ __pycache__/

删除数据库记录:

(venv3) [root@CentOS python3-concurrency-pics-02]# mongo MongoDB shell version v3.6.6 connecting to: mongodb://127.0.0.1:27017 ... > show dbs admin 0.000GB config 0.000GB local 0.000GB mzitu 0.036GB > use mzitu switched to db mzitu > db.dropDatabase() { "dropped" : "mzitu", "ok" : 1 } > show dbs admin 0.000GB config 0.000GB local 0.000GB >

(1) 依序下载

(venv3) [root@CentOS python3-concurrency-pics-02]# python sequential.py

(2) 多线程下载

(venv3) [root@CentOS python3-concurrency-pics-02]# python threadpool.py

(3) 异步下载

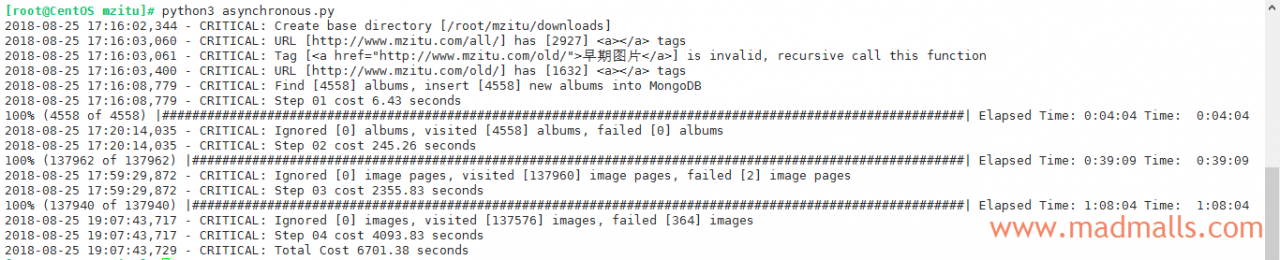

(venv3) [root@CentOS python3-concurrency-pics-02]# python asynchronous.py

3.2 后台运行爬虫脚本

全站下载虽然只有 16 万多张图片,但上面分析过,总请求数差不多有 30 多万次,所以耗时比较久,为防止不小心关闭 Shell 客户端而导致 SSH 断开,将使用 screen 来将脚本运行为后台任务:

[root@CentOS ~]# yum -y install screen [root@CentOS ~]# screen -dmS spider [root@CentOS ~]# screen -r spider [root@CentOS ~]# cd /root/python3-concurrency-pics-02 [root@CentOS python3-concurrency-pics-02]# source venv3/bin/activate (venv3) [root@CentOS python3-concurrency-pics-02]# python asynchronous.py

脚本运行的过程中,按 Ctrl + A + D 即可将任务切换到后台运行,此时再关闭 Shell 客户端也没影响了。等待大约 2 小时后:

[root@CentOS ~]# screen -r spider

即可查看下载的结果,如果有失败的请求,很正常,再次执行脚本即可

(venv3) [root@CentOS python3-concurrency-pics-02]# ls -lR downloads/ | grep '^-' | wc -l 138217 (venv3) [root@CentOS python3-concurrency-pics-02]# du -sh downloads/ 16G downloads/

3.3 定时任务自动每日更新

[root@CentOS ~]# crontab -e 执行上述命令后,将打开vim编辑器,新增如下两行内容: # 爬取 www.mzitu.com 美女图片 30 23 * * * /usr/bin/python3 /root/python3-concurrency-pics-02/asynchronous.py

将在每天晚上 23:30 自动执行爬虫脚本,查看 cron 定时任务是否执行:

[root@CentOS ~]# tail -f /var/log/cron Aug 27 23:30:01 CentOS CROND[6256]: (root) CMD (/usr/bin/python3 /root/python3-concurrency-pics-02/asynchronous.py) Aug 27 23:30:01 CentOS CROND[6257]: (root) CMD (/usr/lib64/sa/sa1 1 1)

更多 cron 知识请参考: http://www.madmalls.com/blog/post/how-to-schedule-tasks-in-linux-with-at-and-cron/

代码已上传到 https://github.com/wangy8961/python3-concurrency-pics-02 ,欢迎 star